Dans un contexte d’annonces enthousiastes, Microsoft a récemment déclaré que la machine a surpassé l’humain pour la tâche de transcription de parole en texte, dite « speech-to-text ». Comment faut-il prendre ce type de déclarations, avec quels espoirs et quelles précautions ? L’histoire récente de la reconnaissance de la parole, intimement liée à celle de l’intelligence artificielle et des apprentissages profonds, apporte un premier élément de réponse, mais l’enquête nécessite aussi un décryptage des métriques utilisées et des conditions de test pour comprendre les véritables enjeux encore à venir dans ce domaine en pleine transformation, qui commence à entrer dans les salles de marché de grandes banques.

1. Progrès et annonces fracassantes

À partir de 2012, une série de communications attirent l’attention du grand public sur la technologie vocale : Microsoft communique sur les réseaux de neurones profonds (Clayton, 2012), puis démontre la reconnaissance et la traduction simultanée de l’anglais vers le chinois (BBC News, 2012). La même année, le New York Times consacre un article à Google Brain, pour ses résultats en reconnaissance d’image, également appliqués en reconnaissance de parole (Markoff, 2012). À partir de 2016, une course au taux de reconnaissance s’engage entre Microsoft, Google et IBM, et, à l’été 2017, Microsoft annonce que la machine surpasse l’humain dans la tâche de transcription de la parole (Xuedong, 2017).

Est-ce la fin de l’histoire en reconnaissance automatique de parole et le début d’applications rêvées, enfin exemptes de toute erreur d’interprétation ? Pas exactement. Alors comment démêler le vrai du faux, le fantasmé du prometteur ? Étudions d’abord la part de science derrière ces annonces.

2. Le lien avec l’intelligence artificielle

L’engouement actuel pour ce qu’on nomme l’IA, acronyme d’intelligence artificielle, a la même base technologique que les récents progrès en reconnaissance de parole : l’apprentissage profond, c’est-à-dire l’apprentissage à base de réseaux de neurones dotés non seulement d’une couche d’entrée et d’une couche de sortie, mais aussi d’un grand nombre de couches dites « cachées ». Ce modèle imite, toutes proportions gardées, l’organisation du cortex cérébral humain (voir Schéma 1).

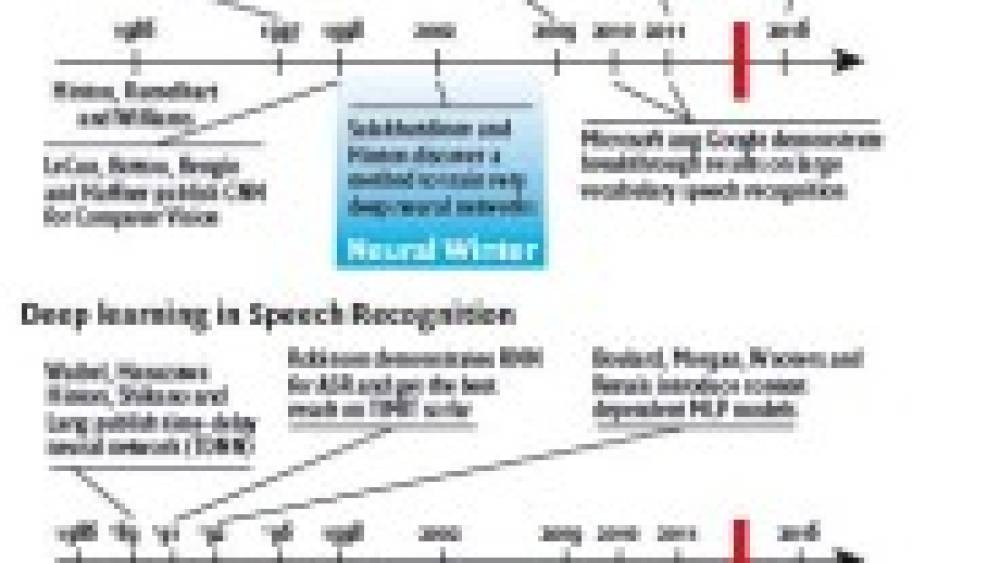

Il faut rappeler que cette famille de modèles a d’abord été développée en reconnaissance d’image, puis en reconnaissance de parole, avant d’être utilisée pour la résolution de problème et de jeux, avec le succès retentissant du projet Google DeepMind / AlphaGo, qui a battu le champion du monde au jeu de Go. D’autres champs d’application plus récents sont notamment la traduction automatique et le traitement du langage naturel. La reconnaissance d’image et de parole sont en quelque sorte les filles aînées de l’IA actuelle.

3. Mythe ou réalité ?

L’accélération des avancées en reconnaissance de la parole, comme dans l’ensemble du champ de l’intelligence artificielle, est un fait objectif. Google annonce avoir divisé son taux d’erreur par deux, voire par quatre, entre 2012 et 2017. Ce type de progrès se retrouve chez la plupart les acteurs en pointe sur le domaine. Or, pour trouver une amélioration d’une telle ampleur, il faut remonter à au moins trois ou quatre décennies en arrière.

4. Une perspective historique sur la reconnaissance de parole

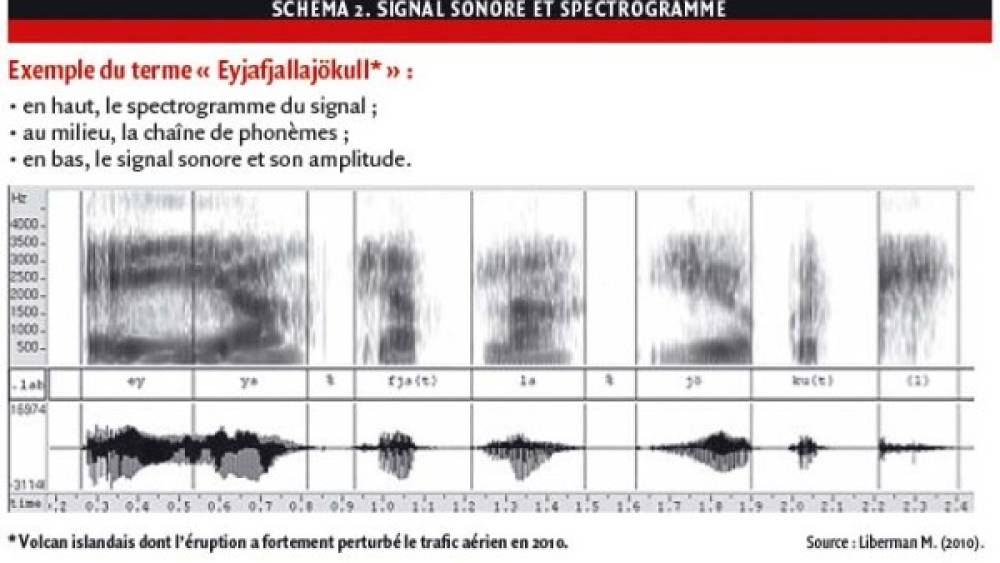

Le type de rupture que nous vivons aujourd’hui avec les réseaux de neurones profonds n’est pas sans rappeler celle que représenta, dans les années 1960-70, l’avènement des approches statistiques face aux systèmes experts en vogue. Ces derniers s’appuyaient sur des arbres de décisions pour classifier les consonnes et les voyelles (appelés « phonèmes »), en fonction de caractéristiques telles que le voisement – si le son véhicule ou non le timbre de la voix –, le caractère plosif – si le son est marqué ou non par une phase de fermeture du larynx avant d’être prononcé, tels « p », « t », « k », et leurs variantes voisées « b », « d », « g », etc. La plupart de ces propriétés sont visibles dans le spectrogramme (voir Schéma 2), c’est-à-dire l’analyse fréquentielle du signal au cours du temps (Rabiner et Juang, 1993).

Théoriquement, un ensemble de distinctions éclairées pouvait identifier « en cascade » chacun des sons prononcés. En réalité, l’espace de réalisation acoustique ne se laisse pas enfermer si facilement : il est vaste, variable et plein d’ambiguïtés locales, en fonction des locuteurs, du contexte, du bruit ambiant, etc. Par ailleurs, les transitions entre phonèmes sont souvent subtiles et les vitesses d’élocution éminemment variables.

Pour capturer ces variabilités, des modélisations statistiques – chaînes de Markov cachées (HMM) et mélanges de gaussiennes (GMM) – commencèrent à être utilisées. Cette approche probabiliste, largement basée sur les données, semblait éloigner la communauté scientifique des lumières de la connaissance et de l’intelligibilité des modèles, mais s’avéra redoutablement plus performante que les systèmes experts, d’autant qu’elle coïncida à la fois avec les compétitions lancées par l’agence de défense américaine ARPA/DARPA – qui donnèrent lieu aux premiers grands corpus de données d’apprentissage – et avec les progrès exponentiels dans les capacités de calcul des microprocesseurs, se mettant à suivre la fameuse « loi de Moore » de doublement de capacité tous les 18

C’est de cette époque – au milieu des années 1980 – que daterait la phrase mythique et controversée du regretté Fred Jelinek, grande figure de l’apprentissage supervisé et non supervisé, alors directeur du groupe de recherche en parole chez IBM, qui aurait déclaré : « À chaque fois qu’un linguiste quitte le groupe, le taux de reconnaissance augmente ». Phrase au statut légendaire, même si elle n’est pas nettement attestée. En tout état de cause, l’approche statistique HMM-GMM régna sans partage – ou presque – pour les trois décennies qui suivirent, jusqu’à être détrônée tout récemment par les réseaux de neurones profonds (voir Encadré).

Nous savons à présent que les annonces de percée majeure sont justifiées, mais qu’en est-il des comparaisons de performances entre machine et humain ?

5. Comprendre les mesures de performance de la reconnaissance vocale

La mesure généralement utilisée pour évaluer les systèmes de « speech-to-text » est le taux d’erreur de mots (Word Error Rate – WER). Elle consiste à additionner toutes les erreurs de mots, à savoir substitutions, insertions et délétions de mots, et diviser par le nombre total de mots dans la transcription de référence : WER = (S + I + D)/N.

Un WER de 10 % correspond à un taux de reconnaissance de 90 %. Cette métrique n’est pas parfaite, puisqu’elle donne notamment la même importance à toutes les erreurs, alors que certaines ont beaucoup plus d’impact que d’autres au regard de l’application visée, mais elle a le mérite d’être rigoureuse et standard, ce qui permet des comparaisons dans le temps et entre systèmes.

6. Ce que disent les évaluations de Microsoft, IBM, Google et Baidu

Quand Microsoft, IBM, Google ou Baidu – le « Google chinois » – comparent le taux d’erreur de la machine au taux d’erreur de transcripteurs humains, ils évaluent la compétence de transcripteurs humains extérieurs aux conversations, et non celle des interlocuteurs eux-mêmes, qui auraient un taux d’erreur bien plus proche de zéro. Par ailleurs, les erreurs commises par les systèmes automatiques sont généralement de nature différente de celles commises par des humains.

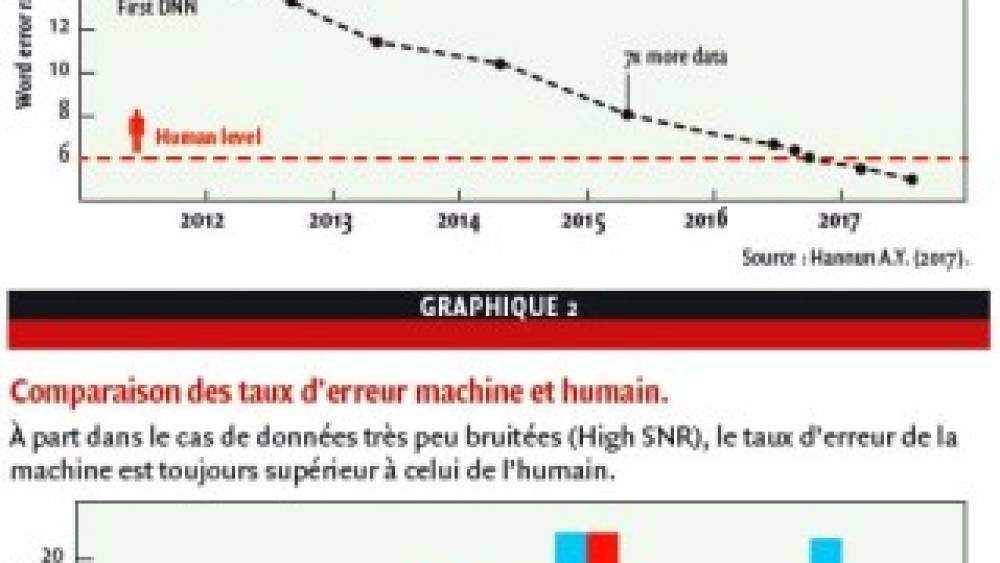

Le Graphique 1 montre que le taux d’erreur de la transcription automatique est passé en dessous du taux d’erreur des transcripteurs humains. Mais ces chiffres sont mesurés sur 20 ou 40 conversations téléphoniques issues du corpus « Switchboard », collecté aux États-Unis en 2000 et réputé pour sa qualité audio particulièrement propre.

Les équipes de Baidu (Amodei et al., 2016) ont démontré (v. Graphique 2) que beaucoup de cas mettent encore la technologie en difficulté : notamment les accents anglais non américains, les accents non natifs, la parole très bruitée. Les enjeux d’amélioration ne manquent donc pas, malgré les récents progrès annoncés.

7. Conclusion

Les annonces de progrès fantastiques en transcription de parole ne sont pas usurpées : elles sont liées à l’apprentissage profond, ainsi qu’à l’accroissement des capacités de calculs et des données d’apprentissages, phénomènes qui impactent par ricochet tous les autres domaines de l’intelligence artificielle. En revanche, les comparaisons de performances rangeant la machine devant l’humain sont contestables et correspondent, au mieux, à un cas de figure isolé et particulièrement favorable : l’anglais américain énoncé dans un environnement très peu bruité. Les accents anglais non américains, les accents non natifs, la parole très bruitée restent autant de champs où la transcription de parole a encore des marges de progrès devant elle.

8. Épilogue

Que signifient ces avancées pour la transcription des traders en salle de marché ?

Dans le contexte d’entrée en vigueur de MiF2 et d'élévation du risque réglementaire (Rocchi, 2017), la transcription automatique est pressentie comme un atout formidable pour aider la conformité bancaire dans les salles de